https://community.amd.com/t5/ai/experience-the-deepseek-r1-distilled-reasoning-models-on-amd/ba-p/740593

RyzenAIでDeepseekを動かせそうなので動かしてみる。

動作したPCスペックはこちら

AMD Driverのインストール

Graphicの周りとRyzenAIのドライバーの更新を行う

LM Studioのインストール

公式Link:LM Studio – Discover, download, and run local LLMs

RyzenAI用LM studio:https://lmstudio.ai/ryzenai

RyzenAI用LM studioからWindows環境で使用するので、対応したインストーラーをダウンロード&実行

右上のSkip onboardingを選択

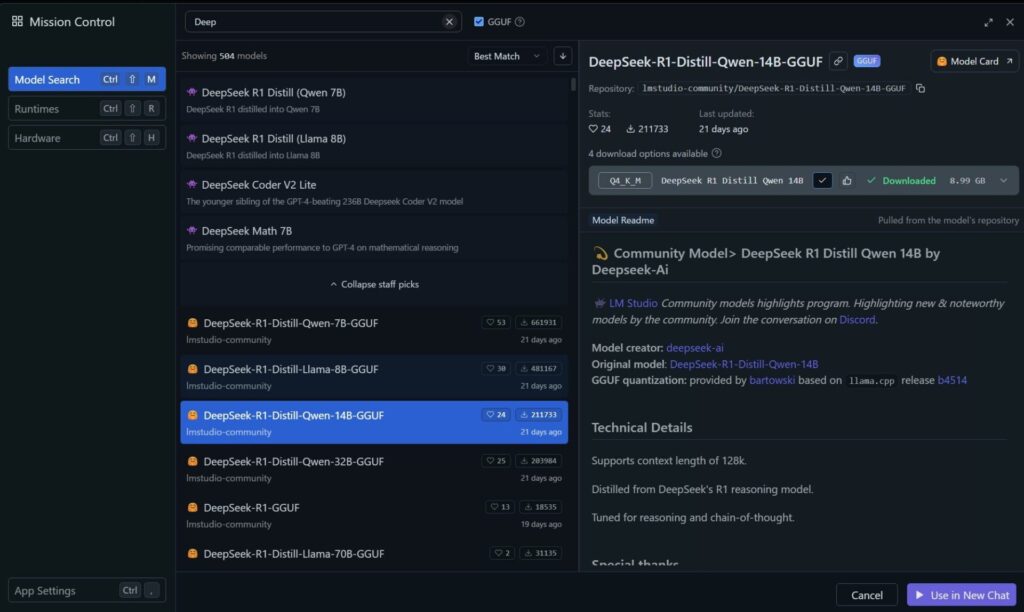

Deepseekのダウンロード

DeepSeek-R1-Distill-Qwen-14B-GGUFを選択して、Q4_K_Mが選択された状態で、モデルのダウンロード

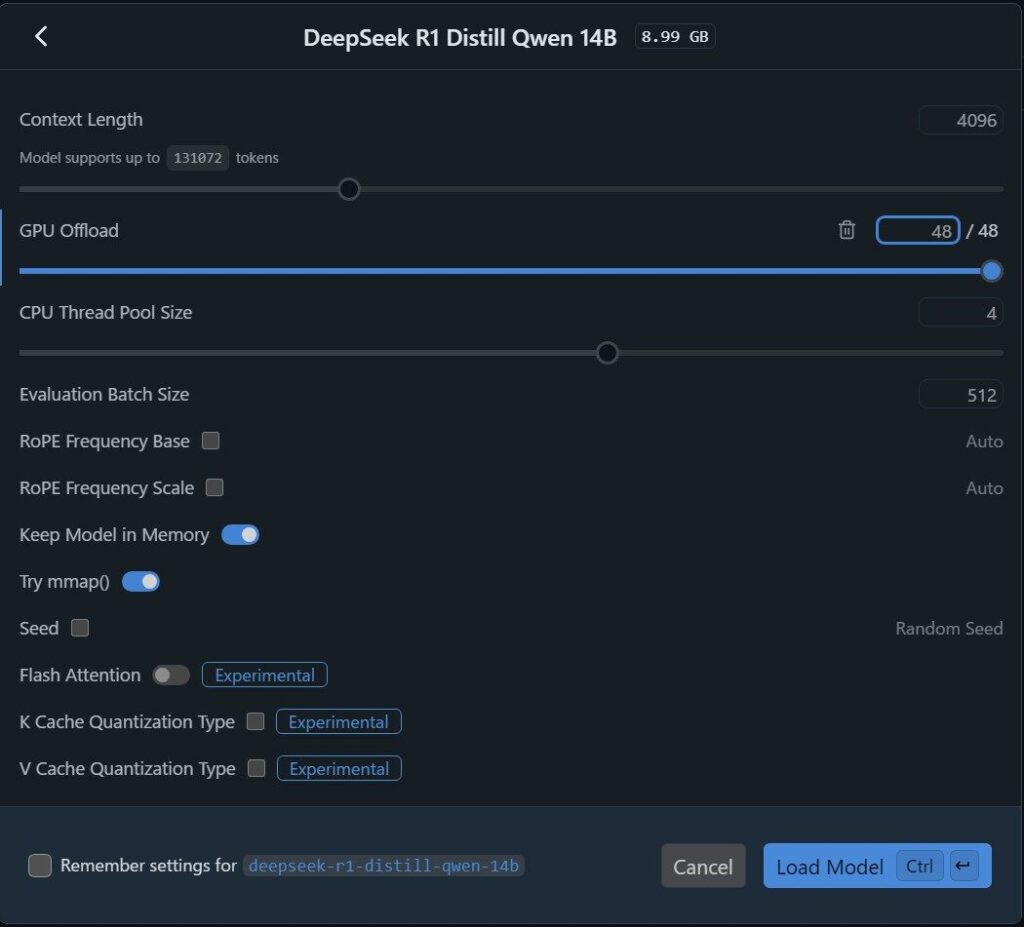

GPUのOffloadのスライダを最大まで移動させてLoad Modelを実行

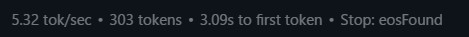

実行結果

5 tok/secなのでいまいち遅い・・・

DeepSeek-R1-Distill-Qwen-1.5B-GGUFで実行した結果

早いけど、生成する内容が支離滅裂で文章になっていなかったので、使い勝手は悪そう

なぜかNPUではなくGPUで動作していたので、期待どおりではなかったが、このAPUではこの辺が限界なのかな

まとめ

5. まとめ

✅ RyzenAIでDeepSeekを動作させることは可能

✅ しかし、期待したNPUではなくGPUで動作してしまった

✅ APU環境では14Bモデルは遅く、1.5Bモデルは品質が微妙

今後の最適化として、NPUオフロードの有効化や量子化設定の見直しを試してみたいと思います!